Qu’est-ce qui vous fait dire qu’on est rentré dans une nouvelle phase du capitalisme ?

Jonathan Martineau : Si nous parlons d’un nouveau stade historique du capitalisme, c’est parce que nous avons constaté une nouvelle articulation, une configuration inédite des mécanismes d’exploitation et d’extraction qui caractérisent tout mode de production capitaliste. Notamment une nouvelle forme d’extraction, celles des données, qui participe maintenant directement à la valorisation économique et à l’accumulation du capital. Une forme qui a permis la création d’un nouveau modèle d’affaires à l’orée des années 2000, dont Google en est le pionnier, mais qui va déborder très rapidement de la sphère du web. Aujourd’hui, on peut observer un secteur économique basé en majeure partie sur le big data, c’est-à-dire l’extraction massive de données et de leur valorisation. Ce modèle d’affaires s’est immiscé dans tous les secteurs de l’économie, de l’agriculture à la finance, du secteur industriel au commerce de détail. Après la crise de 2007-08, on peut clairement noter des changements dans les orientations des flux d’investissements. On voit que les compagnies de la tech, les GAFAM, prennent le dessus sur le plan de la profitabilité et de la capitalisation boursière sur les grandes compagnies extractives ou financières, c’est-à-dire les acteurs qui dominaient le classement jusqu’ici.

Ce capitalisme algorithmique se développe dans une double conjoncture historique. D’une part l’essoufflement du néolibéralisme, la forme précédente, mondialisée et financiarisée, du capitalisme qui était somme toute assez génératrice d’instabilités. La crise de 2007-08 en signe la fin de règne. Le capitalisme algorithmique s’appuie sur ce néolibéralisme déclinant tout en le dépassant. D’autre part, au même moment, pointe une révolution technoscientifique dans le champ des intelligences artificielles (IA) qui permet d’automatiser de nombreux processus dans des machines algorithmiques apprenantes et de les décliner à de nombreuses applications marchandes.

Jonathan Durand Folco : Si d’autres auteur·rices utilisent le terme de « capitalisme de données » ou encore de « capitalisme de plateforme » pour le qualifier, nous avons préféré le terme « algorithmique ». Car dans ce modèle centré sur l’extraction de données personnelles, celles-ci servent à deux choses : d’un côté à être monétisées pour générer des revenus et de l’autre à entrainer des IA basées sur l’apprentissage automatique profond.

Ces différentes technologies algorithmiques se déploient dans de multiples dimensions de nos existences. Ce n’est pas simplement un système économique nouveau, mais aussi, comme le dit Nancy Fraser, un « nouvel ordre social institutionnalisé ». Nous passons en effet de plus en plus de temps devant les écrans, au travail comme dans nos loisirs : toute une économie de l’attention est déployée par les grandes plateformes qui usent de tous les stratagèmes pour nous garder le plus longtemps possible en ligne. Ce sont autant de médiations dans nos relations au monde qui entrainent des transformations importantes dans tous les domaines. Ainsi, de nouvelles formes de pouvoir émergent et différents phénomènes affectent la vie démocratique. Au niveau du travail, la gestion algorithmique reconfigure des dynamiques d’exploitation et de surveillance. Les logiques algorithmiques reconfigurent nos rapports interpersonnels. Et même à un niveau plus intime, elles influencent également la manière dont on se représente soi-même.

En quoi certains aspects du capitalisme algorithmique menacent-ils la vie démocratique ? Qu’est-ce que ça crée ou amplifie de phénomènes délétères pour le débat public ?

JDF : On pourrait commencer par évoquer le quasi-monopole des plateformes numériques au travers desquelles passent les discours publics, le commentariat, ou les nouvelles d’actualité. On peut penser à Facebook, Instagram, Messenger, What’s app qui sont des plateformes détenues par une seule entreprise : Meta. Mais aussi au réseau Tik Tok et à, Twitter désormais X racheté par Elon Musk… L’information dans l’espace public transite à travers ces dispositifs tenus par ces mégacompagnies. Ce qui soulève bien sûr d’énormes enjeux démocratiques.

Au Canada, le gouvernement canadien a ainsi récemment adopté une loi pour essayer de redistribuer des revenus des plateformes numériques vers les médias locaux et nationaux. La réponse de Meta a été de bloquer toute possibilité de partage de nouvelles d’actualité des médias sur leurs réseaux. Ce qui fait que maintenant, sur ces plateformes, la circulation et le partage de l’information sont devenus plus difficiles : les gens font des copier/coller, des partages d’écran de certaines nouvelles d’actualité… On réalise qu’on est complètement à la merci de certaines entreprises. Or, le fait que ces grandes entreprises privées aient un impact si grand sur le gouvernement, même lorsque vient le temps de réglementer l’industrie, fait ressortir des enjeux démocratiques de base en termes d’organisation de l’espace public ou du rapport État-entreprises.

L’espace public, indispensable à la vie démocratique, passe de plus en plus par la médiation des réseaux sociaux. Il y a évidemment des enjeux importants sur la qualité de la discussion publique avec des formes de cyberintimidation, d’agressivité, d’insulte au lieu d’un échange – si on l’idéalise — d’arguments apaisés et raisonnés entre êtres humains autour d’une table ou dans une assemblée citoyenne. Cette dynamique-là nuit à la délibération publique.

Quels phénomènes concernant le débat public vont être amplifiés par les logiques algorithmiques ?

JDF : En permettant une personnalisation poussée des contenus sur les fils d’actualité de personnes en fonction de leur champ d’intérêt, les logiques algorithmiques vont produire plusieurs effets. D’une part, ce filtrage établi sur la base des traces numériques que ces personnes laissent constamment va accentuer le phénomène des « bulles de filtre » : on va me proposer des contenus similaires à ceux que je consulte déjà. Cela m’incite à me replier sur ma bulle informationnelle qui devient en quelque sorte un système de propagande individualisée. Et d’autre part, cela va favoriser les « chambres d’écho » c’est-à-dire des espaces où des groupes de personnes partagent les mêmes idées et idéologies. Cette répétition va renforcer les croyances du groupe au lieu de susciter de la confrontation d’idées. Ce qui conduit parfois à la polarisation des discours dans l’espace public.

Les réseaux sociaux détenus par le capital algorithmique permettent d’accélérer la circulation des informations disponibles. Mais en même temps celle de la désinformation. Or, on sait qu’une fausse information sensationnaliste circule sept fois plus rapidement qu’une nouvelle véridique. Dès lors, la capacité à avoir accès à une information de qualité dans l’espace public et a s’y retrouver vis-à-vis de cette fragmentation des contenus devient très complexe.

On a parfois l’impression de vivre dans des univers de sens complètement différents. Or, pour avoir une forme de démocratie vivante, il faut avoir des significations communes partagées, une certaine cohésion sociale. D’autant que ces outils et dynamiques de manipulation des informations peuvent être mobilisés tant à des fins publicitaires qu’électorales. Ou encore, elles permettent à des lobbys d’entreprises ou des puissances étrangères de brouiller le débat public, de semer le doute permanent.

JM : On pourrait encore citer la question des nouvelles formes d’hypertrucage (deep fakes en anglais). Des copies ou des trucages de déclarations de politicien·nes sont par exemple diffusées sur les réseaux. Cela amène là-aussi beaucoup de confusion dans la parole publique.

Autre enjeu démocratique, l’égalité. Or, les logiques algorithmiques vont avoir tendance à automatiser des systèmes de discrimination existants basés sur des formes d’oppression comme le racisme, le sexisme ou l’homophobie. Car les algorithmes qui prennent les décisions reproduisent les biais qui se trouvent dans les données d’entrainement des IA. Non seulement, on reproduit ces formes d’oppressions-là, mais on rend également beaucoup plus difficile la résistance envers ces formes de domination dès lors qu’elles sont encapsulées dans la technologie.

Les outils développés à la base pour le microciblage publicitaire peuvent représenter un danger pour la démocratie et menacer jusqu’au processus électoral lui-même. On peut donc aujourd’hui microcibler les citoyen·nes et influencer opinions et votes ?

JM : Aujourd’hui les entreprises sont capables de savoir par du traçage de données (comme l’historique d’achat) si une femme est enceinte et lui envoyer ensuite des publicités ciblées de produits pour bébé. De même, en ciblant certaines personnes à partir de leur profil psychologique et de leurs interactions avec des contenus politiques, on est en mesure, de cibler des électeur·rices potentiel·les pour les mobiliser. L’idée avec ce microciblage, ce n’est pas de réaliser une manipulation de masse en contrôlant l’information, mais plutôt de radicaliser certaines opinions pour faire émerger un vote de contestation. Dans le cas des élections américaines de 2016, il s’agissait ainsi de diffuser des messages qui dépeignaient Hillary Clinton de façon extrêmement négative. L’idée, en créant ce vote anti-Clinton, c’était moins de faire changer d’avis des gens que d’être sûr qu’ils aillent effectivement déposer ce vote de contestation alors qu’ils ne seraient pas forcément allés voter sinon. On peut ainsi agir sur des votes très serrés par des interventions ciblées qui, en s’additionnant, peuvent avoir un impact et faire basculer un vote. On l’a vu aussi pour le Brexit.

Vous dites dans votre livre que ce que le capitalisme algorithmique produit, ce sont des comportements. Quels sont les mécaniques qui nous influencent et les dangers d’une régulation par les algorithmes des populations hors d’un contrôle démocratique ?

JM : Les travaux de Shoshana Zuboff ont notamment éclairé les mécanismes de cette nouvelle forme de pouvoir qui n’utilisent pas la force ou la contrainte directe, mais plutôt le nudging, c’est-à-dire l’orientation des comportements sur base de l’analyse en profondeur de quantité massive de données. On peut alors créer des incitatifs pour des comportements qui vont être jugés bénéfiques. Ou au contraire, des systèmes de petites punitions pour en limiter d’autres.

Par exemple, les compagnies d’assurance testent actuellement des systèmes de surveillance installés directement dans les voitures. Ainsi, si les capteurs indiquent que vous respectez les limites de vitesse, que vous freinez à tous les stops, etc. alors la police d’assurance va vous coûter moins cher. On va donc pouvoir vous attribuer un score. Mais attention, on va aussi être capable de monter votre prime en temps réel si vous brulez un feu rouge. Ou encore empêcher le démarrage de votre voiture si nous n’avez pas payé vos primes… Si on présente souvent ces technologies algorithmiques comme étant à l’avantage de l’usager·ère, il est bien sûr évident qu’il s’agit avant tout d’un outil pour les compagnies afin de maximiser la rentabilité de leurs services.

Cette nouvelle forme de pouvoir, dite de gouvernementalité algorithmique, se déploie donc au niveau micro. Elle part d’un mécanisme de publicité ciblée, mais déborde largement la simple idée de vouloir faire acheter quelque chose à quelqu’un et s’immisce dans beaucoup d’autres sphères de l’existence. Ainsi, on oriente les comportements non seulement en contrôlant les interfaces d’informations. Mais aussi, puisqu’on en sait beaucoup sur les utilisateur·rices — leurs préférences, leurs goûts -, on va venir stimuler certaines pratiques en agissant au niveau de leurs désirs et de leurs pulsions. C’est donc un contrôle comportemental qui ne nécessite pas de faire appel à la police ou aux menaces mais qui va passer par les incitatifs comportementaux. Il ne s’agit donc pas de façonner des subjectivités c’est-à-dire de vouloir dire aux gens quoi penser. Mais, plus subtilement, de faire faire pour amener aux résultats souhaités.

Il devient dès lors important de savoir quels sont ces comportements jugés désirables et par qui ils sont édictés. Un exemple récent et massif concerne tous les comportements de prudence qui respectaient certaines normes de la santé publique lors de la pandémie de Covid. Ceux-ci avaient été décidés par des comités d’experts et non pas par des représentant·es. Il faut donc toujours se demander non seulement s’il s’agit d’un comportement souhaité parce qu’il est rentable pour les entreprises ou bien parce qu’il est bénéfique pour la société. Mais aussi si un contrôle démocratique s’exerce bien sur la définition de ces comportements.

Les logiques algorithmiques conduisent aussi à l’instauration de plus en plus de processus de décision automatisées. Le jugement humain se voit petit à petit remplacé dans toute une série de prises de décisions administratives, policières, judiciaires… Est-ce que vous pouvez donner des exemples et indiquer les menaces que cela fait peser en termes d’égalité ?

JDF : On utilise généralement les IA dans le but d’économiser du temps et des moyens humains. Cette automatisation progressive des décisions dans différents systèmes sociaux fait en sorte que l’être humain se retrouve à la remorque de certaines décisions. Ce qui n’est pas sans poser de nombreuses questions. Par exemple, dans la sphère judiciaire, aux États-Unis, cela a été testé pour déterminer des libérations conditionnelles. Des systèmes algorithmiques vont décider sur base du comportement antérieur d’un prisonnier et de leur profil sociodémographique si leur libération est risquée ou non. Or, on va s’apercevoir que des personnes noires vont moins avoir accès à la libération conditionnelle parce que les algorithmes d’IA ne sont pas neutres, ne sont pas du tout objectifs, mais qu’ils sont entrainés à partir de données produites par des humains, à partir de circonstances d’injustice antérieure. On risque donc fort de reproduire des biais en termes de racisme notamment. Et de les systématiser au travers des algorithmes.

Mais plus encore, se pose la question de l’explicabilité des décisions, des résultats qui sont issus de ces IA. Or, la plupart des algorithmes sont reconnus dans le champ de l’apprentissage automatique comme étant des boîtes noires. C’est-à-dire qu’on ne connait pas forcément la manière dont ils ont procédé pour arriver à leurs conclusions.

On fait passer par des algorithmes une sphère croissante de décisions qui peuvent avoir un grand impact sur la vie des gens comme l’accès à un prêt bancaire, l’attribution d’allocations sociales, l’admission en université, l’obtention d’un visa… Le jugement humain ne semble plus être là que pour estampiller des décisions prises par la machine. Dans le même temps, en raison de la non-transparence des algorithmes, on aura souvent beaucoup de mal à justifier et légitimer la décision. Il faut donc vraiment se demander le type de décision que nous souhaitons automatiser. Par exemple, celles qui ont très peu d’impact sur la vie des gens ou celles dont les critères qui ont mené à la décision peuvent être facilement explicables. Mais il est impératif de tracer des lignes rouges pour que certaines décisions à fort impact sur la vie des gens et/ou au processus opaque continuent d’être prises par des êtres humains.

JM : Aux États-Unis, mais aussi au Canada et dans plusieurs pays d’Europe des techniques algorithmiques de prédiction du crime sont utilisées afin d’orienter et de maximiser des ressources policières par ailleurs soumises à l’austérité. Leurs algorithmes sont basés sur des données des territoires où agissent ces polices pour prédire où le crime a le plus de chances de se produire et par qui il a le plus de chances d’être commis. Or, puisque c’est basé sur l’historique des arrestations et du système judiciaire — historiquement et racistes -, on aura une surreprésentation dans les profils à surveiller de certains groupes. Aux États-Unis, des Afro-Américains ou au Canada des personnes autochtones. Ce qui va entrainer un ciblage et une surveillance accrue de ces mêmes populations et de leurs lieux de vie. Ce qui va alors faire augmenter le nombre d’arrestations. On voit comment la logique algorithmique va agir comme une véritable prophétie autoréalisatrice puisqu’évidemment, plus il y a de la surveillance dans ces zones-là, plus on va y trouver des crimes. Les systèmes algorithmiques peuvent donc avoir tendance à automatiser certaines formes de discriminations, certaines formes d’oppression.

Il y a un grand écart entre la présentation des outils technologiques présentés comme neutres, qui nous débarrasseraient des décisions délétères prises par certains policiers racistes et la réalité qui montrent que le racisme systémique s’automatise en raison des données qui nourrissent la machine.

Nos outils critiques et stratégies d’action, forgés pour enrayer le néolibéralisme sont-ils encore suffisants face à ce capitalisme algorithmique qui lui succède ? Devons-nous renouveler profondément notre logiciel critique ?

JDF : Comme le capitalisme algorithmique intègre, dépasse et même parfois entre en tension avec certaines caractéristiques de la rationalité néolibérale, la critique du néolibéralisme reste pertinente à bien des endroits. Mais on ne peut pas s’en contenter aujourd’hui. Car on est déjà rentré dans une nouvelle forme de société basée sur la puissance des algorithmes et de l’IA. C’est pourquoi il faut réarticuler la critique du néolibéralisme et la combiner à celle de la gouvernementalité algorithmique et à des nouvelles logiques d’optimisation algorithmique et de surveillance. C’est une des tâches de la critique sociale de débusquer ces formes de pouvoir dans le monde social en vue de le transformer et en vue d’appuyer des luttes pour l’émancipation.

Peut-on subvertir les algorithmes et se les approprier ? Ou bien au contraire est-ce qu’il faut tout faire pour limiter les espaces où ils interviennent ?

JDF : Il faut d’une part se réapproprier les technologies, par des communs, par différentes alternatives non capitalistes, par les infrastructures contrôlés démocratiquement à petite ou grande échelle. Mais il est selon nous indispensable de faire décroitre la sphère du numérique et de l’IA en mettant en pratique collectivement un principe d’autolimitation qu’on a nommé technosobriété. Il s’agit de limiter l’infrastructure technologique pour en diminuer l’empreinte écologique et énergétique, de se contenter sur l’état actuel de la technologie plutôt que de vouloir updater matériel et logiciels sans arrêt, de réduire les usages de certaines technologies numériques là où ce n’est pas essentiel ou nécessaire etc. Mais notre position n’est pas antitechnologique non plus. On croit que même dans un monde post-capitaliste on aura besoin des outils informatiques et des IA dans certains contextes précis pour servir le bien commun. Seulement, l’usage doit en être déterminé par des processus de réflexions démocratiques et des débats publics

Le capital algorithmique – Accumulation, pouvoir et résistance à l’ère de l’intelligence artificielle

Jonathan Durand Folco & Jonathan Martineau

Ecosociété, 2023

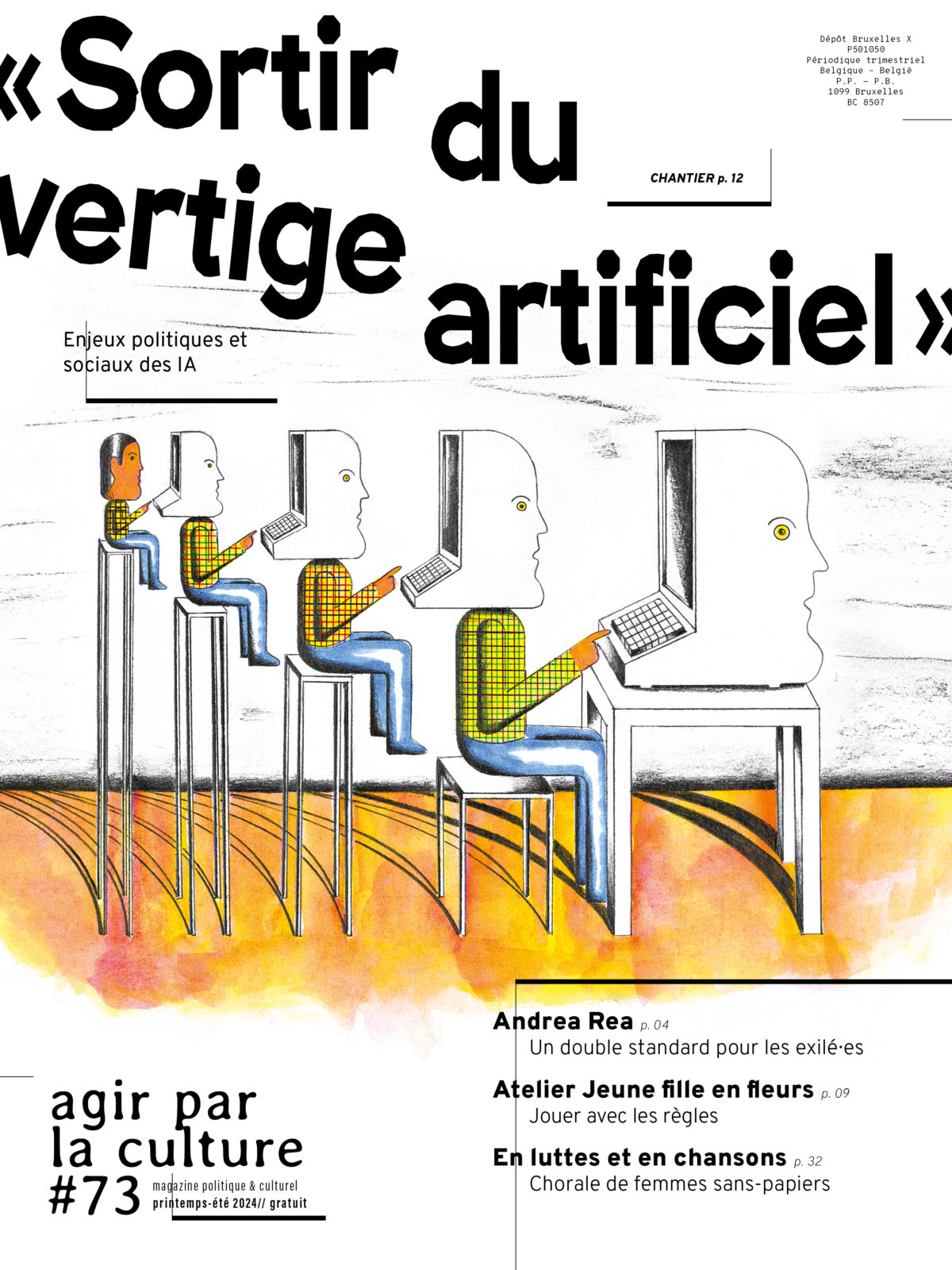

Retrouvez de nombreuses interventions sur les enjeux sociaux, politiques et environnementaux des intelligences artificielles dans notre grand chantier en ligne « Sortir du vertige artificiel ».