« L’essor de l’intelligence artificielle (IA) a ouvert de nouvelles perspectives, mais il soulève également des inquiétudes profondes quant à son impact sur notre liberté de pensée et notre capacité à exercer un esprit critique. Les algorithmes utilisés dans les systèmes d’IA peuvent créer des bulles de filtrage, où les utilisateurs sont exposés uniquement à des informations et des perspectives qui renforcent leurs croyances existantes. Cette limitation de l’exposition à la diversité des idées peut entraîner un appauvrissement de notre pensée critique et de notre capacité à remettre en question les normes établies.

De plus, les biais intégrés dans les algorithmes d’IA peuvent renforcer les stéréotypes et les préjugés, affectant ainsi notre capacité à prendre des décisions de manière objective et éclairée. Par exemple, dans le domaine du recrutement, des algorithmes basés sur des ensembles de données historiquement biaisés peuvent favoriser certaines catégories de personnes au détriment d’autres, perpétuant ainsi les inégalités existantes.

L’automatisation croissante des décisions, alimentée par l’IA, représente également un défi majeur pour notre esprit critique. En confiant certaines tâches décisionnelles à des systèmes automatisés, nous risquons de perdre notre capacité à évaluer de manière critique les informations et à prendre des décisions en toute autonomie. Cette dépendance accrue à l’IA peut affaiblir notre sens de l’initiative et nous rendre vulnérables à la manipulation.

Pour contrer ces risques, il est impératif de mettre en place des mesures réglementaires et des normes éthiques strictes pour encadrer le développement et l’utilisation de l’IA. La transparence des algorithmes doit être garantie, permettant ainsi aux utilisateurs de comprendre comment les décisions sont prises et d’identifier les éventuels biais. De plus, il est essentiel d’investir dans l’éducation et la sensibilisation pour renforcer la capacité des individus à évaluer de manière critique les informations et à résister à la manipulation.

En conclusion, l’IA présente des risques significatifs pour notre liberté de pensée et notre esprit critique, mais ces défis peuvent être relevés grâce à une approche proactive et collaborative. En adoptant des politiques réglementaires appropriées et en investissant dans l’éducation, nous pouvons préserver notre capacité à penser de manière indépendante et à prendre des décisions éclairées dans un monde de plus en plus dominé par la technologie. »

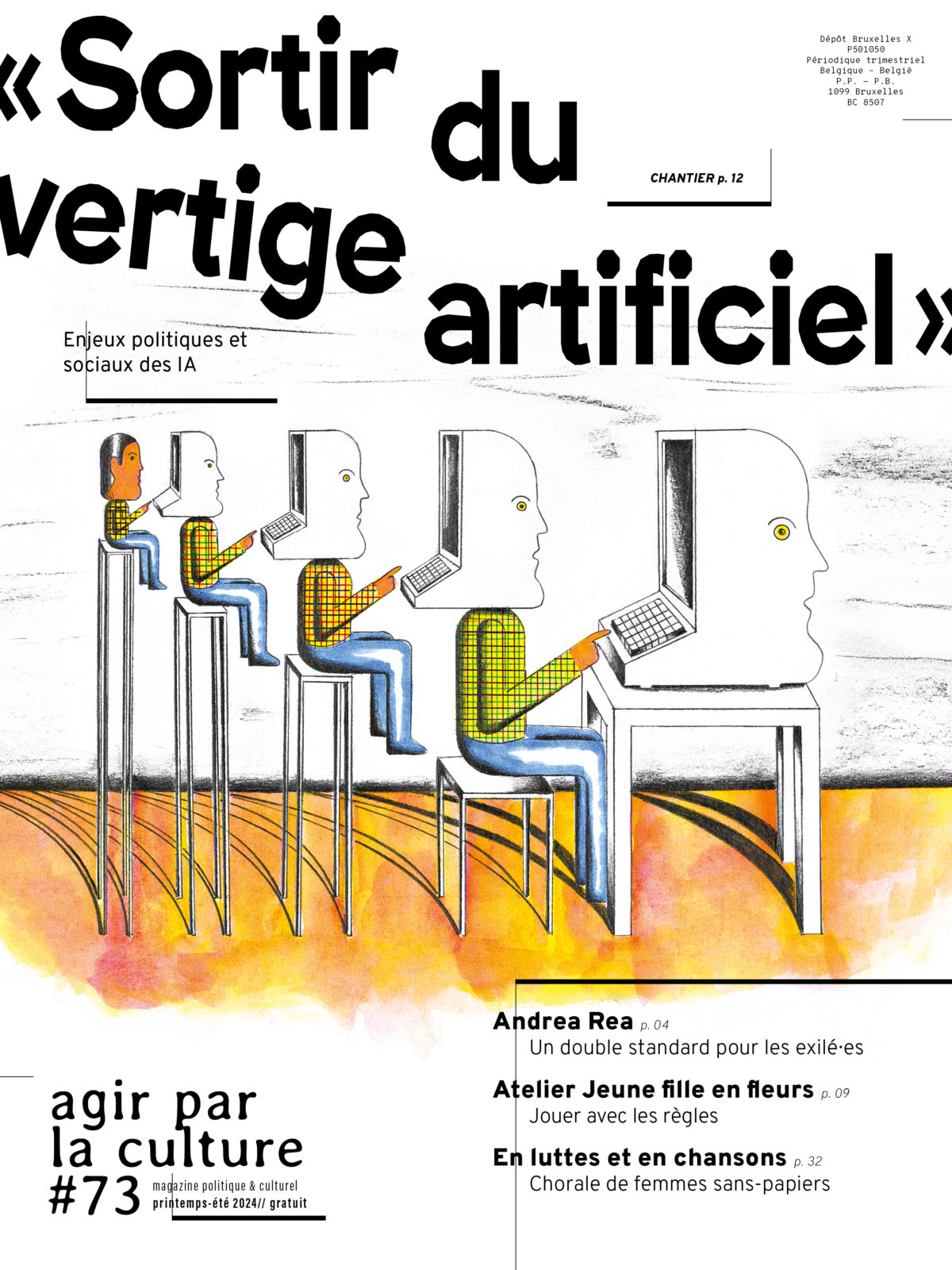

Retrouvez de nombreuses interventions sur les enjeux sociaux, politiques et environnementaux des intelligences artificielles dans notre grand chantier en ligne "Sortir du vertige artificiel"