La promesse de la « ville intelligente », la smart city, c’est celle d’une ville qui résoudrait toutes les contradictions, toutes les tensions, c’est celle d’arriver à un ordre harmonieux des comportements humains, à une société pacifiée, gérée, qui tourne rond. Est-ce que la promesse des intelligences artificielles (IA) plus généralement, c’est celle d’une société qui pourrait fonctionner sans aucun accroc, sans aucun conflit ?

Ça dépend des secteurs, mais en ce qui concerne par exemple la sécurité et la gestion de l’espace public, cela recoupe effectivement des aspects de la ville intelligente. On y vise cette promesse d’harmonie grâce à la machine. On a l’idée que des technologies, par exemple un modèle de prédiction de la criminalité en temps réel ou bien encore des caméras de surveillance avec reconnaissances faciales intégrées, pourraient à elles seules faire baisser la criminalité. C’est un argument de vente puissant et pourtant, on sait bien qu’il ne suffit pas de mettre des caméras pour faire diminuer la survenance des crimes et délits qui vont généralement simplement se déplacer. Ce n’est pas parce qu’on est vu qu’on ne commet pas des crimes. En fait, on vend une technologie clé sur porte comme une solution à un problème. Or, une technologie n’est jamais une solution à problème sans la pratique sociale qui l’accompagne, qui l’encadre, qui l’intègre dans un usage ou dans une situation.

Autre exemple, celui de l’éducation et de la pédagogie. Depuis des décennies maintenant (mais avec un net coup d’accélérateur pendant la pandémie de Covid 19) se développe un marché florissant appelé l’Ed tech (Education technology), notamment aux États-Unis, où des entreprises cherchent à vendre de nouvelles technologies aux écoles : radio, télé, ordinateur, internet, tablettes, casque de réalité virtuelle… À chaque génération, on a promis un meilleur apprentissage, plus personnalisé, plus différencié et de meilleurs résultats scolaires grâce à ces nouveaux outils. Or, 40 ans plus tard, on utilise toujours essentiellement le manuel papier… Et les télés, magnétoscopes, ordinateurs portables et autres écrans s’entassent dans des placards après quelques essais. L’institution scolaire, pour le meilleur ou pour le pire, résiste parce qu’il y a des cultures, des pratiques pédagogiques d’enseignant·es ou de directeur·ices que ces technologies ne prennent pas en compte dans leur déploiement.

Cette idée que la technologie pourrait résoudre un problème sans qu’il y ait une participation humaine, c’est une pensée fondamentalement magique qui traduit ce que le philosophe Gilbert Simondon nommait un défaut de culture technique. On est dupé par des promesses de technologiques toutes puissantes parce qu’on manque de la culture technique qui d’une part nous ferait comprendre le fonctionnement d’une technologie, et d’autre part nous ferait saisir aussi les limites de cette technologie. Et bien souvent j’ai l’impression qu’on nous vend des technologies en nous promettant des effets en fait impossibles à atteindre. Ça en dit long sur nos attentes en tant que société… On continue de dépenser de l’argent public sur des caméras de surveillance en pensant qu’elles vont faire advenir une société sans crimes, mais on ne s’attache pas aux causes du problème qui crée la criminalité, à ses facteurs sociaux et économiques par exemple. On refoule simplement le problème quand on pense qu’il existe une solution magique.

Il y a un apparent consensus dans les collectivités publiques, les institutions, les grandes entreprises : il faudrait mettre l’intelligence artificielle partout. Pourquoi un tel enthousiasme ? Est-ce qu’il y a quelque chose de l’ordre de l’utopie ?

Cet enthousiasme provient d’abord du fait que le marché de l’intelligence est en pleine croissance à l’échelle mondiale. Le terme « smart » ou « intelligent » est accolé sur tout et n’importe quoi pour mieux vendre, y compris des dispositifs où il n’y a pas d’informatique !

Quelque chose d’étrange se passe au niveau de notre représentation quasi animiste : on croit que les objets s’animent d’eux-mêmes. Cela me fait penser à des récits de science-fiction de Philip K. Dick où le monde devient étrange précisément parce que c’est un monde qu’on a façonné nous-mêmes. En effet, notre monde n’a jamais été aussi rempli d’artifices, tout notre quotidien est saturé de technologies. Et en même temps, c’est un monde qui devient de plus en plus étrange, duquel on semble être aliéné, dans le sens où on ne sait pas comment ça fonctionne, ça parait obscur, ça parait magique, on a l’impression que ça nous échappe…

Mais pourquoi un tel engouement des pouvoirs publics ?

Sur le plan politique, je dirais que ça vient quand même répondre en partie à un souci de gouverner avec le moins d’ingérences et de coercition possible. Ça fait partie de cette nouvelle forme de gouvernement qu’Antoinette Rouvroy et Thomas Berns ont qualifié de gouvernementalité algorithmique. C’est-à-dire l’idée qu’on gouverne de moins en moins par le recours aux lois et à la coercition, aux obligations et de plus en plus par les chiffres, par des classements, par des suggestions, par des recommandations.

La Commission européenne est par exemple très forte pour ça. Elle produit des classements, les meilleurs élèves de tel ou tel domaine, et va élaborer des recommandations, une liste de « bonnes pratiques ». Libre à vous de suivre ces recommandations ou non. Mais si vous êtes le dernier dans le classement, ce sera de votre faute. C’est la logique de la honte, de la pression des pairs.

Or, avec les IA actuelles, on est dans des modèles avec des milliers voire des centaines de milliers de variables. Bien plus larges donc que la statistique actuelle qui sert souvent de guide à l’action publique. Avec les IA, on aurait suffisamment de données sur chaque profil pour cibler et tailler sur mesure ces « bonnes pratiques », ces recommandations et pour prédire les comportements de chacun·e. On n’aurait plus besoin de penser des classes sociales, des catégories sociales ni des profils sociodémographiques car chaque individu est une source intarissable de données en temps réel, chaque individu fait lui-même et « volontairement » rapport de ses activités en utilisant ses différents dispositifs connectés…

L’échelle de la gouvernementalité algorithmique, c’est l’individu ?

Oui ou plutôt l’infra-individuel : tous les micros-comportements souvent imperceptibles pour la conscience individuelle. Et sur le registre politique, c’est un levier intéressant quand on a envie d’atteindre des objectifs politiques sans forcer les gens, sans avoir l’impression d’être interventionniste, d’être invasif dans la vie des individus. C’est ce qu’on appelle la politique des nudges. Le nudging en anglais, c’est le petit coup de coude qu’on donne pour inciter quelqu’un à adopter un comportement. La question, c’est de savoir comment on peut façonner un environnement de telle sorte à favoriser ou à défavoriser certains comportements à l’échelle collective.

C’est une manière de gouverner qui est très puissante et quasi imperceptible sur base des recommandations. Je parlais de la Commission européenne mais les recommandations sont évidemment des pratiques qu’on retrouve sur toutes les plateformes et réseaux sociaux qu’on utilise au quotidien. Une recommandation de contenu, c’est tout simplement une prédiction de notre prochain comportement : il y a X ou Y chance qu’on clique, qu’on consomme tel ou tel film ou qu’on achète tel ou tel produit. Si ce n’est pas le cas si la prédiction est contredite, ce n’est pas grave, le modèle proposera autre chose. Il apprendra de son erreur et demain, il nous proposera une nouvelle prédiction. Il dit simplement : « Vous allez peut-être aimer ça », « Vous allez peut-être faire ça », « Vous allez peut-être acheter ça »… Mais on est toujours libre de ne pas le faire. On a l’impression qu’on est presque gouverné par soi-même, parce que le modèle ne fait que prédire un comportement possible de notre part. Mais il ne nous ne dit pas ce qu’on doit faire.

La promesse de l’IA, c’est aussi celle de pouvoir gouverner « en temps réel »…

On retrouve en effet de nouveau cette obsession du temps réel. Le rêve, c’est d’avoir une vue continue et en temps réel de la société, sans l’effet de latence des statistiques qui sont celles d’il y a six mois ou d’un an, qui sont partielles, etc. Or, la nouvelle génération d’IA est intéressante pour les gouvernants à cet égard puisqu’elle peut prédire quasiment en temps réel des comportements qu’un gouvernement mettrait des mois à récolter avec la méthode classique des statistiques. Avec à la clé la possibilité d’ajuster à ces données presque immédiatement les paramètres sociaux et économiques. C’est en tout cas l’idéal promis.

Ce faisant, est-ce qu’on n’est pas en train d’évacuer le temps plus long du débat démocratique ? Celui du conflit entre des intérêts divergents lorsqu’il s’agit de prendre une décision. Est-ce que cette idéologie de l’intelligence artificielle clôture le débat démocratique en disant quelque chose comme : la machine qui voit tout sait mieux que nous, elle va donc décider grâce à sa gigantesque capacité de calculs ce qui est le meilleur pour nous ?

C’est un des risques. On peut l’illustrer avec les algorithmes d’optimisation, ces algorithmes dont la fonction est de trouver un optimum. Par exemple en pondérant un tas de variables pour établir le chemin le plus court à prendre comme quand on utilise Google Maps.

Alors, si ça parait relativement évident et pas trop problématique d’optimiser un chemin pour élaborer son itinéraire, l’optimisation de la société en revanche pose plus de questions… Parce que l’optimum veut dire le mieux, le meilleur, ce que l’on veut atteindre comme objectif. Or, dans une société, on n’est jamais d’accord sur le but, sur l’optimum, sur ce qu’il faudrait optimiser. Ce n’est jamais clair et jamais établi une bonne fois pour toutes. C’est la nature même d’une société d’être conflictuelle, au sens que nous ne définissons pas tous et toutes de la même manière ce vers quoi elle doit tendre. Mon collègue Jérémy Grosman travaille par exemple sur les tensions sociales et économiques générées par l’utilisation de l’algorithme d’optimisation des préférences scolaire par la Fédération Wallonie-Bruxelles.

Et effectivement, de ce point de vue, c’est de plus en plus le cas quand on utilise des algorithmes d’optimisation dans des services publics, dans des entreprises privées pour embaucher ou gérer le personnel, pour proposer des meilleures polices d’assurance… ils présentent l’optimum calculé par la machine comme étant la meilleure solution. Ce qui est difficilement débattable car on a ni la culture technique, ni le temps et les compétences pour vraiment pouvoir contester cette optimisation. D’autant qu’on subit une cadence telle qu’on a du mal à se situer sur des horizons de 10 ou 20 ans.

On assiste à une accélération ?

Oui, et cette accélération, c’est quelque chose que la critique sociale a déjà énoncé lors de la Révolution industrielle. Pensons à Charlie Chaplin et au « Temps modernes » où l’ouvrier est pris sur la chaine de montage, il n’arrive plus à suivre, il doit travailler au rythme de la machine… C’est quelque chose qu’on revit peut-être aujourd’hui sous une autre forme : on est pris dans des boucles de prédictions et de recommandations comportementales où on est sans cesse sollicités, donc projetés dans la seconde qui va suivre. Il y a quelque chose d’épuisant.

Par contre, l’erreur, ce serait de dire que c’est la faute à la machine. Tout comme ce n’était pas la faute de la machine industrielle, ce n’est pas la faute des algorithmes de recommandations aujourd’hui. C’est là que réside un enjeu politique, économique et social important. Et il nous faut répondre à certaines questions pour le traiter : qu’est-ce que l’on attend collectivement de certaines technologies ? Qu’est-ce que l’on désire de la technologie ? Réinjecter cette question du désir me semble importante tant sur l’échelle individuelle que collective. C’est comme ça qu’on peut voir des collectifs se former autour des technologies, qui ne sont pas contre la technique mais qui désirent autre chose, un autre avenir, d’autres formes de société à travers la technique.

On a un rapport de fétichisation de la technologie et l’intelligence artificielle n’y échappe pas. Est-ce qu’une des nouveautés avec le fait que l’IA s’immisce de plus en plus dans nos quotidiens, c’est une accélération de cette fétichisation ?

Je crois ce qu’on fétichise avant tout, c’est le caractère automatique des technologies, des machines. Leur soi-disant capacité à fonctionner toutes seules sans jamais tomber en panne avec cet idéal suivant lequel elles remplaceraient l’humain dans toute une série de tâches et de fonctions. Et qu’elles s’alimenteraient toutes seules, qu’elles s’autoreproduiraient — un vieil imaginaire, présent déjà au 17e siècle avec une obsession pour l’horloge perpétuelle ou la quête de la machine à mouvement perpétuel. On est fasciné par des machines qui ne s’arrêteraient jamais et dont on pourrait simplement contempler le travail. Or, je crois qu’il y a aujourd’hui beaucoup de ça dans le discours sur l’IA avec cette idée qu’elle va nous remplacer, c’est-à-dire fonctionner et travailler toute seule. Car les IA sont loin de pouvoir marcher toutes seules ou de se substituer à nous. Au contraire, elles n’ont jamais été aussi intégrées dans la vie sociale. Ces technologies sont en effet utilisées pour aider le diagnostic médical, recommander des contenus culturels sur les plateformes, établir des polices d’assurance, attribuer des crédits, lutter contre la criminalité… Elles font partie d’activités et de pratiques sociales qui sont inséparables des données que les utilisateur·trices produisent. Et inséparables aussi des utilisateur·trices qui les utilisent et qui sont le public concerné par ces technologies.

Dans votre livre vous décrivez la smart city comme une ville augmentée de technologies et de services de prédictions en temps réel, quelque chose qui fonctionnerait tout seule, pour ainsi dire sans habitant·es ou malgré ses habitant·es. Est-ce qu’on pourrait aussi le dire justement pour d’autres applications, d’autres lieux où se déploient les intelligences artificielles ? Où les usagers de services publics ou les patients d’un hôpital y seraient perçus comme une variable très secondaire ?

Ce qui s’est souvent passé quand on parle de remplacement du travail humain dans des services comme les supermarchés, les hôpitaux, les fast-foods, ou encore les call-centers, c’est que le travail humain avant d’être remplacé par la machine a été mécanisé ou rendu computable, c’est-à-dire réduit à un travail qui pouvait être exécuté par une machine. C’est très flagrant dans les call-centers de service clientèle. Les standardistes ont été habitué·es à suivre un script duquel ils et elles ne pouvaient pas dévier. Évidemment ça n’a pas été très compliqué à partir de ce moment-là de remplacer des humains par une machine pour ce travail déjà très robotisé.

Après ce qui est toujours fascinant, et c’est là que le fétiche de l’automatisation revient, c’est qu’on voudrait que ça marche à tous les coups, on voudrait que ça remplace définitivement le travail humain mais ça n’arrive jamais ! Une machine qui fonctionne parfaitement 100 % du temps n’existe pas. Les choses semblent marcher de manière automatique un moment. Mais quand par exemple ça tombe en panne, on est rappelé à la matérialité des choses, au fait que tout ça dépend d’ordinateurs, d’électricité, de câbles, de main d’œuvre, de maintenance, etc. L’essence même du fonctionnement technique, c’est d’être intermittent, défaillant, de nécessiter de la maintenance.

C’est quand même assez rare que le chatbot [robot conversationnel NDLR] résolve vraiment le problème pour lequel on appelle. En fait ça sert surtout pour une entreprise à gérer le flux d’appels, à désaturer les lignes téléphoniques, voire à décourager les clients qui appellent… Le cas des caisses automatiques l’illustre bien aussi : on aurait du mal à imaginer un supermarché qui arrive à marcher sans aucun employé·e humains. Les machines marchent une fois sur deux, différents codes d’erreurs s’affichent sur leurs écrans. Et l’agent humain devient alors une sorte de médiateur entre la machine et le client, celui qui vient régler, qui vient communiquer avec la machine. De manière générale, l’intégration de nouvelles technologies, notamment de l’IA, ne va pas évacuer l’humain mais va le déplacer dans la configuration.

Dans les discours sur les IA, revient souvent l’idée qu’elles pourraient se retourner contre nous, contre leurs créateurs. Selon vous, cela pourrait renvoyer à la vieille peur du dominant qui craint le soulèvement des esclaves, des colonisé·es, des subalternes. Est-ce que cela voudrait dire que l’IA repose sur un imaginaire colonial ?

Pour répondre correctement à cette question, je dois faire un détour par la philosophie de Gilbert Simondon qui lit l’histoire de notre rapport occidental à la technologie dans la prolongation du rapport maitre-esclave. Aristote voyait en effet une continuité entre l’outil et l’esclave : dans les deux cas, ce sont des choses — dans la Grèce antique, rappelons que l’esclave était considéré comme une chose. Ils n’ont tous deux pas de fin en soi : leur objectif est donné soit par celui qui utilise l’outil, soit par le maitre. Sauf que l’esclave est une chose étrange puisqu’il peut se révolter, refuser d’obtempérer, fuir. Alors que l’outil lui obtempère toujours, en tout cas pour des outils simples comme un marteau ou une charrue. Mais, progressivement, en devenant de plus en plus complexe, en devenant des machines, les outils se sont mis aussi parfois, à la manière des esclaves, à ne plus obtempérer, à dysfonctionner, à tomber en panne.

Cet imaginaire de l’esclave persiste et il se situe en arrière-fond du fétiche de l’automatisation. Ainsi, quand on veut remplacer des travailleur·euses humain·es par des machines, la préoccupation première n’est pas de les libérer du travail, mais plutôt de produire plus rapidement, de ne pas avoir à gérer de l’insubordination, des grèves, des syndicats, des grossesses, des congés paternité, etc. Il faut penser ce fétiche de l’automatisation dans cette histoire longue construite autour de l’idée qu’une bonne machine, c’est un esclave. Et d’ailleurs c’est un langage qui est repris dans l’histoire de l’informatique, on en trouve des marques partout : commande, exécution, des logiciels « esclaves » et « maitres », l’étymologie du mot robot renvoie aussi à l’esclave.

Les machines sont devenues des objets complexes qui semblent parfois n’en faire qu’à leur tête. D’ailleurs, c’est comme ça qu’on en parle quand elles ne font pas ce qu’il faudrait. On s’énerve contre son ordinateur, on dit : « aujourd’hui, il veut pas ». Et ce n’est pas un hasard si dans l’imaginaire science-fictionnel au cinéma ou en littérature, on voit des robots ou des machines qui se soulèvent. On ne cesse de projeter cette possibilité qu’une machine, tout comme un esclave, un colonisé, un subalterne pourrait bien se révolter un jour. On est quelque part toujours dans une société esclavagiste — coloniale dans le sens où on n’a pas évacué cette fonction-là de notre activité, de notre forme de production. Tant qu’on voudra remplacer des ouvriers humains parce que les ouvriers humains ne sont pas dociles et que les machines le seraient, on gardera la fonction esclave c’est-à-dire quelque chose qui obéit sans broncher. Sortir notre rapport à la technique de ce désir d’obéissance et de contrôle me semble dès lors un enjeu important. Car tant qu’on gardera cette fonction de l’esclave docile conférée à la machine comme une possibilité, elle pourra potentiellement un jour être remplie de nouveau par des êtres humains. Il faut rendre cette relation impossible à penser.

Comment on sort de cet imaginaire délétère ?

Ce n’est pas parce qu’une machine « n’en fait qu’à sa tête » qu’elle se révolte et va nous dépasser, être plus puissante que nous. Si on commence à voir que les techniques sont dans des relations pour ainsi dire sociales avec nous, on n’aura plus une forme de méfiance ou de crainte, mais des comportements de soin, d’attention et de compréhension de l’objet, comme on peut le faire dans d’autres formes de relations sociales. Ce qui ne veut pas dire qu’il faut considérer la machine comme un vivant. Mais il s’agirait de comprendre comment ça fonctionne et pourquoi ça dysfonctionne. Alors aujourd’hui évidemment, c’est compliqué d’attendre ça d’utilisateur⸱ices pour des systèmes d’IA où les ingénieurs qui les conçoivent ont eux-mêmes du mal à comprendre ou expliquer comment ça fonctionne, à fortiori à produire du soin et de la compréhension. C’est là qu’il faut créer et réimaginer des formes de collectifs qui donnent cette puissance d’agir aux utilisateur·ices. Mais aussi réfléchir à comment les institutions publiques pourraient réguler les usages en imposant des normes strictes en termes d’ouverture et de réparabilité sur les entreprises. Aujourd’hui on jette ce qui ne marche plus comme on voudrait, demain il faudra qu’on apprenne à prendre soin, surtout si on veut conserver quelque chose comme notre intelligence.

L’intelligence des villes – Critique d’une transparence sans fin

Tyler Reigeltuth

Météores, 2023

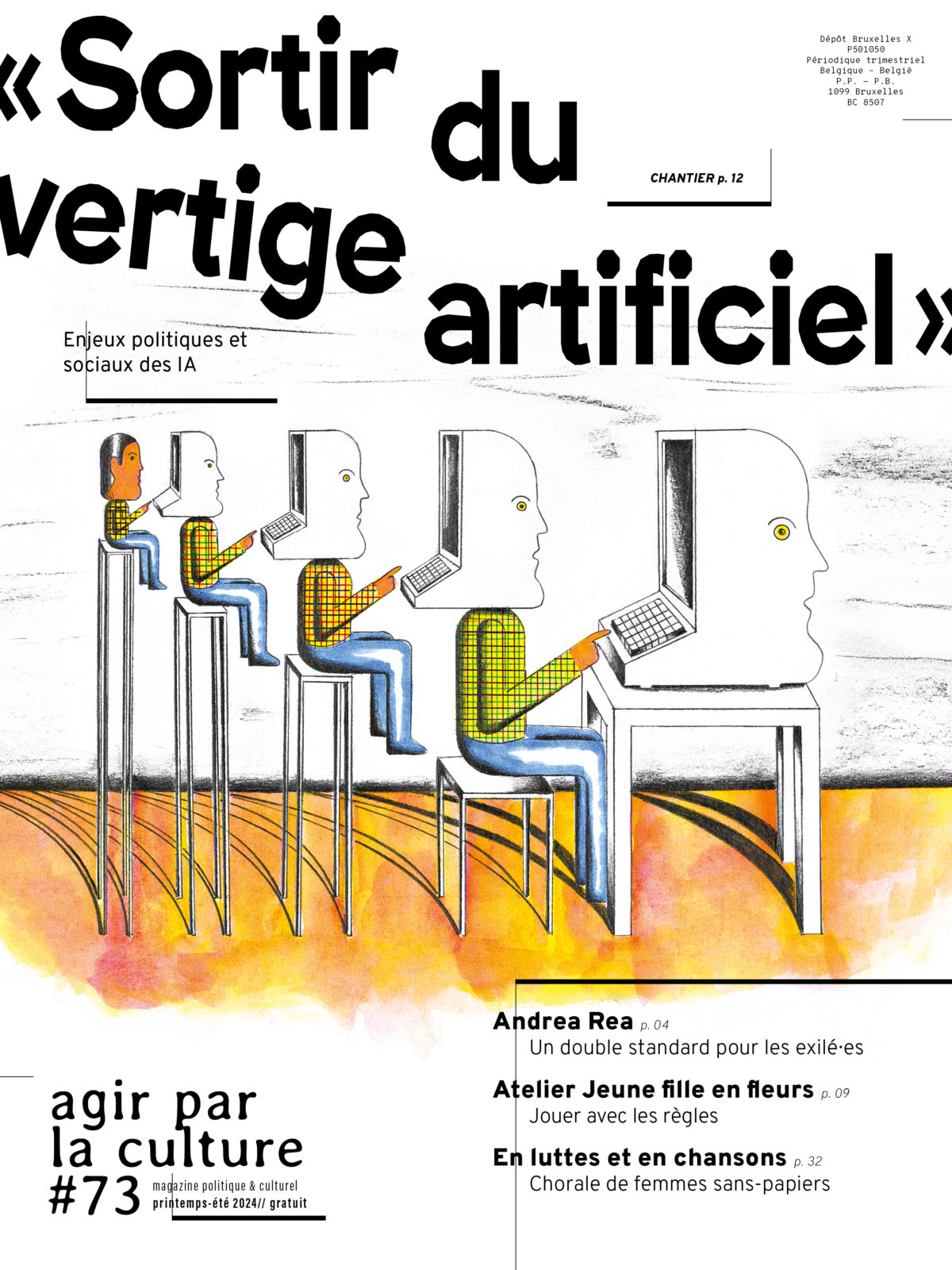

Retrouvez de nombreuses interventions sur les enjeux sociaux, politiques et environnementaux des intelligences artificielles dans notre grand chantier en ligne « Sortir du vertige artificiel ».