Démarré dans les années 1950, le développement de l’IA connait un essor inédit depuis la fin des années 2010. En générant une quantité massive de données, la numérisation grandissante de nos activités a engendré le développement d’une nouvelle génération d’algorithmes autoapprenants (« Machine Learning ») aux applications multiples : reconnaissance faciale, assistants connectés, logistique automatisée, etc. Forte de ces évolutions, l’IA devient un outil d’analyse et d’aide à la décision miracle qui s’insère peu à peu dans tous les aspects de notre société. À écouter ses promoteurs, elle serait une source de solution inépuisable pour résoudre nos problèmes — santé, dérèglement climatique, éducation, insécurité — avec de nouveaux métiers, de nouvelles compétences et surtout, une nouvelle croissance. Les recherches et investissements sur son développement sont plus que jamais au cœur des jeux de compétition qui régissent les rapports de force internationaux : de l’extraction des matières premières, en passant par la conception des systèmes en laboratoire au déploiement de ses applications militaires ou commerciales.

Cependant, dans un monde dicté par une géopolitique capitaliste et impérialiste, cette course à l’IA s’appuie sur un système d’exploitation humain et matériel aux conséquences dramatiques. Comme l’affirme la chercheuse Kate Crawford dans son livre Contre-Atlas de l’Intelligence Artificielle : « L’IA n’est ni artificielle, ni intelligente ». Elle est conçue pour « servir les intérêts des dominants » en formant une « industrie extractive » qui exploite ressources, travailleurs et données. Et ce au détriment des droits humains autant que de l’environnement.

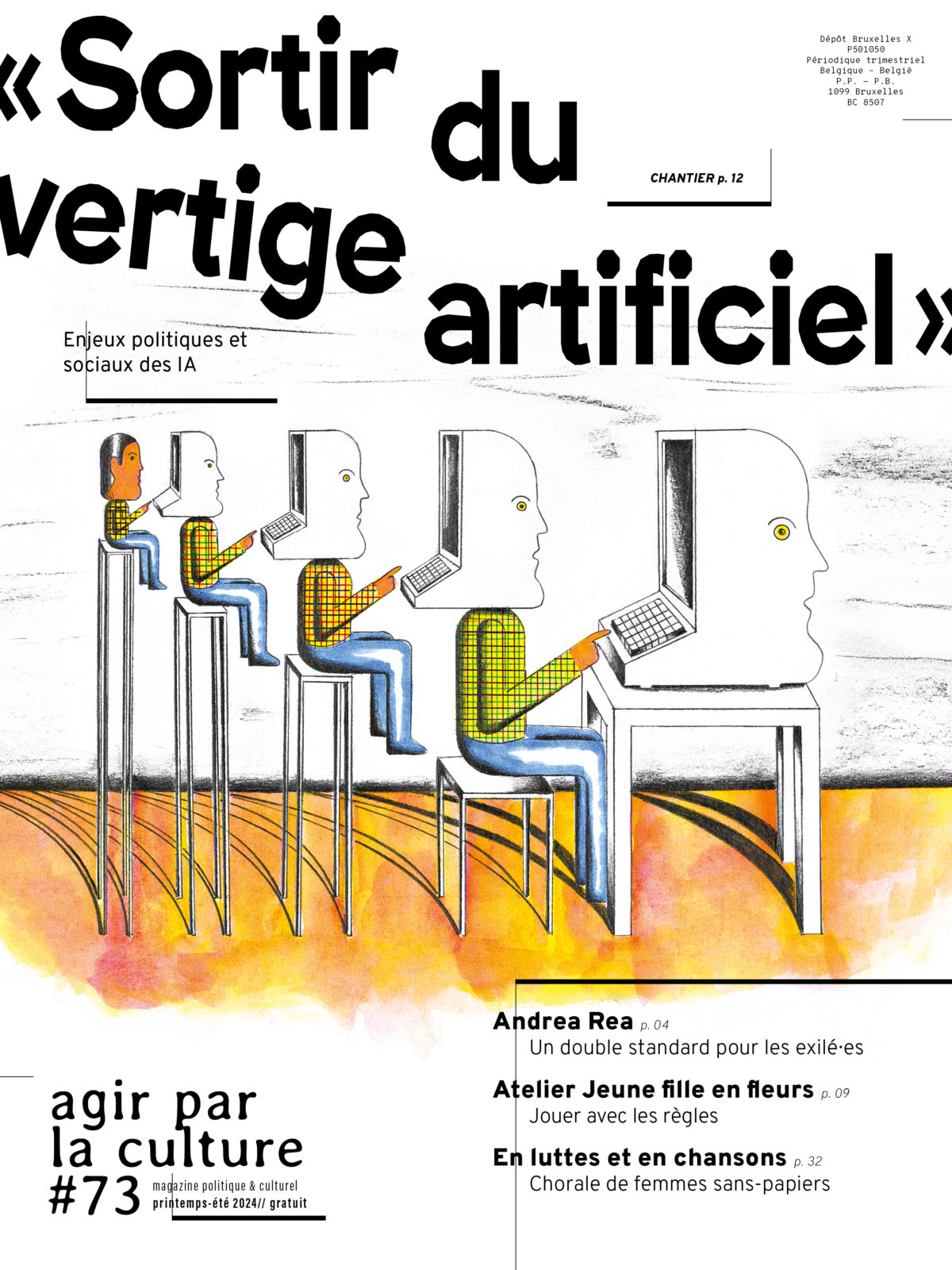

Intelligence « artificielle », exploitation « réelle »

Sous les apparentes optimisations et automatisations de nos activités, les coulisses de l’IA se révèlent en effet bien moins réjouissantes. À commencer par les microtravailleurs qui lui permettent de fonctionner. Si les IA prétendent assister les êtres humains, l’inverse est tout aussi vrai. Loin d’être le seul fruit d’ingénieurs occidentaux et surdiplômés, elle doit aussi son existence à des millions de petites mains humaines chargées d’alimenter, assister et entrainer ses algorithmes au quotidien. Un travail invisibilisé, sous-payé, et fait de microtâches ultrarépétitives : détourer, classer, étiqueter des images, ou bien retranscrire des textes, des vocaux, etc. Surnommés « les annotateurs de données », ces personnes proviennent en majorité des pays du Sud global (Inde, Pakistan, Sénégal, Kenya, Philippines, Venezuela) et travaillent pour quelques centimes ou quelques dollars de la tâche. Derrière leur écran, ils effectuent leurs missions depuis chez eux via des plateformes en ligne ou bien parqués dans des centres géants. Ils travaillent pour le compte de multinationales de la tech ou de start-ups de l’IA. À l’instar de l’entreprise américaine Presto Automation qui s’est récemment fait épingler pour ses discours trompeurs. À la tête d’un service de traitement de commande vocale pour la restauration supposé entièrement automatisé, cette dernière a été contrainte d’avouer qu’elle employait des « agents hors site » dans des pays comme les Philippines pour intervenir dans 70 % des interactions avec les clients.

Pendant que certains algorithmes s’appuient sur de la main‑d’œuvre bon marché, d’autres aspirent allègrement les publications mises à disposition sur la toile. D’autant plus avec l’arrivée d’IA générative permettant de créer des textes, images, sons ou vidéos à la demande. Pour produire, les outils comme ChatGPT (générateur de texte) ou Midjourney (générateur d’image) se servent des contenus disséminés sur le web qu’ils traitent et ressortent différemment. Médias, artistes, auteurs, chercheurs se retrouvent susceptibles de voir leurs travaux pillés et réutilisés à leur insu. Ainsi, le New York Times a récemment attaqué en justice la société Open AI, les créateurs de ChatGPT, en l’accusant d’exploiter gratuitement les productions du journal pour nourrir ses robots. Dans la même lignée, des artistes commencent à utiliser des outils informatiques pour « empoisonner » leurs œuvres avant de les publier sur internet pour les rendre inexploitables par les IA.

Insoutenabilité écologique

L’omniprésence de l’IA se révèle tout aussi vorace sur le plan des ressources : extraction des matières premières, consommation d’eau, d’énergie… Elle s’inscrit dans un monde numérique dont les impacts croissants mettent déjà en péril nombre de territoires et populations à travers le monde. Rien qu’en France, si l’on ne fait rien, l’empreinte carbone du numérique risque de tripler d’ici 2050, bien loin des objectifs de l’Accord de Paris. En outre, les récentes études d’impact sur l’IA, conjuguées aux prédictions de l’industrie, dressent un tableau vertigineux.

La nouvelle demande en énergie engendrée par le développement de l’IA équivaut déjà aujourd’hui à la consommation de petits pays. En 2027 elle atteindrait l’usage annuel de pays comme l’Argentine, les Pays-Bas ou la Suède. Les centres de données, maillon principal nécessaire à l’entrainement et au calcul des modèles, en sont les premiers touchés. Le déploiement massif des IA les oblige à repenser entièrement leur fonctionnement. La raison : l’IA fonctionne sur des processeurs différents que ceux initialement utilisés par les datacenters. Si bien que Meta (la maison mère de Facebook et Instagram) doit interrompre la construction de ses nouveaux centres de données pour y intégrer l’IA. Alors que les gains d’efficacité des datacenters ont permis jusqu’à présent de relativement contenir l’explosion de leur consommation énergétique, l’ensemble des feuilles de route des constructeurs présentent aujourd’hui une augmentation conséquente et fulgurante de leur puissance. Les géants doivent tripler d’ici à 6 ans leur capacité de calcul et de stockage. Google, Microsoft et Amazon ont prévu d’augmenter de 50 % leurs investissements dans le matériel et les infrastructures cloud sur les 3 ans qui viennent. Nvidia, principal fournisseur des processeurs dédiés à l’IA, prévoit de multiplier sa puissance globale par 275 tous les 2 ans contre 8, depuis 10 ans.

Outre le fait de devoir changer le matériel (et donc d’augmenter la pression sur les réserves de terres rares) et d’augmenter les consommations électriques, ces supercalculateurs nécessitent d’énormes quantités d’eau pour être refroidis. L’explosion de l’IA générative est d’ailleurs à l’origine d’importants pics de consommation chez les géants de la tech. C’est ce que révèle une enquête publiée par l’Associated Press en septembre dernier. Elle indique que les rapports environnementaux de Microsoft et Google pointent respectivement une augmentation de 34 % (l’équivalent de 2500 piscines olympiques) et 20 % de leur consommation entre 2021 et 2022. Une croissance « qu’il est juste d’attribuer majoritairement à l’augmentation de l’IA » déclare le chercheur interrogé pour l’enquête Shaolin Ren, co-auteur de l’étude « Making AI less thirsty ». Et en ces temps de crise climatique où les périodes de sécheresses se multiplient, cette consommation accrue inquiète. En Espagne, en Uruguay, aux Pays-Bas, aux États-Unis, partout dans le monde, des tensions émergent dans les collectivités qui voient leur approvisionnement menacé.

Discrimination, surveillance et cyberviolence : un accroissement généralisé des violences ?

Si le fonctionnement matériel de l’IA soulève de sérieux problèmes, il en est de même pour ses applications. Son intégration dans divers domaines — judiciaire, médical, social, culturel — conduit à de graves dérives dont les exemples ces dernières années foisonnent : atteintes à la vie privée, discriminations sexistes et racistes, désinformation et fabrication de fake news, surveillance des populations ou encore exploitation des travailleurs. Depuis le lancement de ChatGPT en novembre 2022, les débats reprennent de plus belle.

Pour ne citer que quelques exemples. Aux États-Unis, l’utilisation par la police de logiciel de reconnaissance faciale connue pour ses biais racistes a entrainé plusieurs arrestations « par erreur » de personnes noires. La dernière en date, Porcha Woodruff, une femme vivant à Detroit ayant passé 11 heures au commissariat alors qu’elle était enceinte de 8 mois. En France, la dématérialisation des services sociaux de la CAF (Caisse d’Allocations Familiales) et la mise en place d’algorithmes de notation des allocataires fragilisent l’accès aux droits des personnes les plus vulnérables. L’automatisation, l’opacité et la simplification des traitements algorithmiques étant incompatibles avec la complexité et la précarité des situations en jeu. Le Mouton Numérique, notre collectif de réflexion technocritique, a d’ailleurs signé une lettre ouverte avec une trentaine d’associations afin d’alerter sur le problème. Toujours en France, l’arrivée des Jeux Olympiques en 2024, a permis la légalisation d’expérimentation de vidéosurveillance assistée par IA. Un dispositif « inquiétant » selon Amnesty International qui menace la « liberté d’expression » et favorise une surveillance « disproportionnée de l’espace public ». Enfin, l’IA générative et la génération croissante de « deepfakes » (contenus vidéo ou audio truqués à l’aide de l’IA) fait craindre un accroissement de la désinformation ou des cyberviolences. Les femmes notamment deviennent la cible de détournements pornographiques. Comme la chanteuse Taylor Swift lorsque de fausses images à caractère sexuel la mettant en scène ont déferlé sur le réseau X. Ou encore ces adolescentes en Espagne victimes de photos trafiquées par l’IA les faisant apparaitre complètement dénudées.

La généralisation de l’intelligence artificielle ne fait qu’exacerber les violences déjà à l’œuvre. Ces dérives ne sont pas de simples « défauts » qu’il suffirait de surpasser ou de corriger. Elles invitent plutôt à repenser profondément la société dans laquelle l’IA s’insère et à lui résister face au futur qu’elle aide à faire advenir. Un avenir, ni soutenable écologiquement, ni souhaitable socialement.

Le Mouton numérique est un collectif de réflexion technocritique

Retrouvez de nombreuses interventions sur les enjeux sociaux, politiques et environnementaux des intelligences artificielles dans notre grand chantier en ligne « Sortir du vertige artificiel ».